¿El mayor acosador en las redes sociales podría ser el mismo algoritmo?

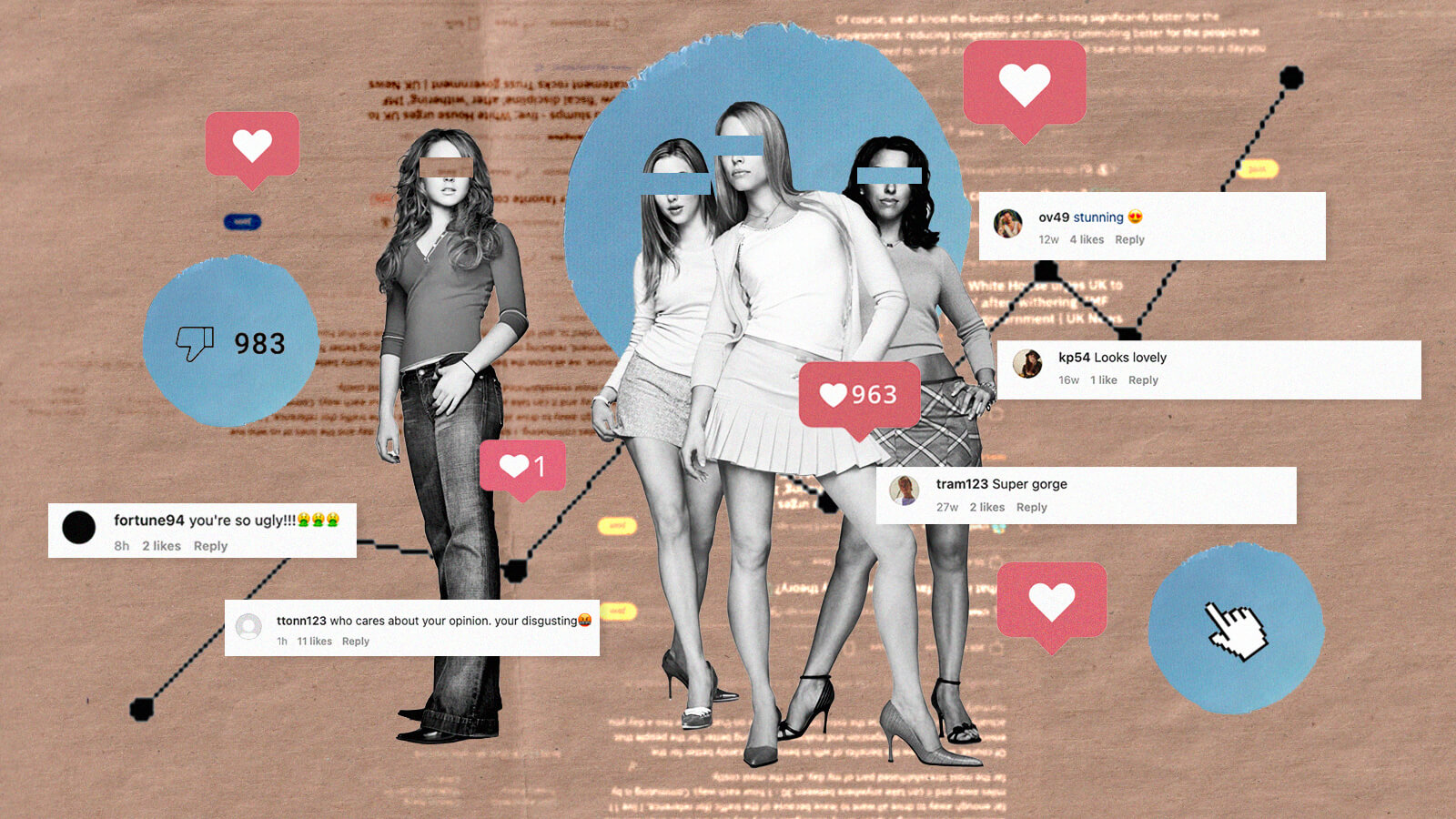

Si el mundo en línea fuera la película Mean Girls, estoy segura de que las plataformas de redes sociales serían Regina George. Es decir, la acosadora. Tiene sentido. Las redes sociales adoran los escándalos, nos alimentan constantemente con chismes y son expertas en decirles a las personas cuándo pueden o no sentarse con nosotros. Pero, evidentemente, la vida real no es como Mean Girls. Las redes sociales determinan cada vez más la opinión pública, afianzando la polarización política y avivando con frecuencia las llamas de la misoginia, el racismo y la intolerancia. Sin embargo, somos nosotros los que impulsamos estas plataformas, iniciando sesión y participando voluntariamente. Un algoritmo por sí solo no podría acosarnos. ¿O sí?

Aunque Instagram —propiedad de Meta— se negó a comentar sobre el tema, un portavoz de TikTok afirmó que el objetivo de su algoritmo es seleccionar contenido para los usuarios en función de sus preferencias. Básicamente, te muestra más de lo que te gusta y lo mide mediante los «me gusta», los seguidores y los videos vistos. En todo caso, esto parecería ser de utilidad, hasta que consideras que, si solo estamos viendo contenido adaptado a nuestros propios intereses, estamos quedando atrapados en cámaras de eco, contribuyendo a una sociedad cada vez más dividida.

Sara McCorquodale, fundadora del estudio de consultoría de redes sociales Corq y autora del libro Influence, dice que, si bien la división no es el objetivo de estas plataformas, eso no quiere decir que no se beneficien de ella. «Se han desarrollado enormes comunidades en línea en torno a temas divisivos, y creo que una cantidad considerable de personas se han vuelto adictas a obtener una reacción y reforzar sus opiniones», afirma. «La adicción las obliga a estar interactuando constantemente con contenido social y esto beneficia a las plataformas de redes sociales, donde el uso diario y la relevancia minuto a minuto son de suma importancia».

El objetivo de un algoritmo es medir y aumentar la participación porque así es como se monetizan estas plataformas: cuanto más tiempo permaneces en ellas, más publicidad pueden mostrarte, y si descubre qué funciona bien, te mostrará más de lo mismo. Ni siquiera tiene que ser algo que hayas buscado, puede ser simplemente un tema de moda. Esto puede explicar por qué el contenido sobre Amber Heard llegó de forma indeseada a tantos de nuestros feeds este verano.

«Las publicaciones críticas tienen más probabilidades de recibir comentarios y ser compartidas que cualquier otro tipo de publicación», dice Camille Carlton, gerente sénior de políticas y comunicaciones del Center for Humane Technology, una organización sin fines de lucro que trabaja para que la tecnología sea socialmente más responsable. «Las palabras moralmente emocionales en los mensajes aumentaron su difusión en un factor del 20 % por cada palabra adicional. Mientras el odio funcione bien seguirá siendo rentable, y mientras la indignación sea rentable, estas plataformas no tienen ningún incentivo para dejar de dirigir el odio en tu dirección».

La indignación es el alma del Internet. Basta con mirar al paciente cero del acoso en línea: la invitada del pódcast At Your Service de la semana pasada, Monica Lewinsky. En 1998, su aventura con el presidente Bill Clinton fue el primer escándalo político que se desató en línea. Los sitios web de chismes nacieron a partir de ese momento y todos nosotros iniciamos sesión para alimentar nuestros intereses más bajos por la indignidad de los famosos. Las redes sociales se han aprovechado de esto, permitiéndonos acosar e intimidar a la vez. De esta manera, nos obligan a no apartar la mirada. «A menudo, el algoritmo mide la participación con el contenido que no necesariamente es lo que realmente te interesa o es bueno para ti», coincide Carlton. «Son las cosas que no puedes dejar de ver».

Sin embargo, el portavoz de TikTok afirma que los usuarios pueden decidir activamente lo que no les gustaría ver, activando los filtros de etiquetas o bloqueando a ciertos usuarios. «Esto requiere que las personas adopten un enfoque proactivo en las redes sociales, en lugar de simplemente desplazar la pantalla hacia abajo de forma pasiva, algo que en este momento puede parecer antinatural», observa McCorquodale. «Además, es la única forma de combatir las cámaras de eco: forzarte a interactuar con contenido de todo el espectro político y temático para obtener un feed más equilibrado y matizado». Entonces, si podemos detenerlo, ¿seremos acosadores sin fuerza de voluntad? «No, nos enfrentamos a un sistema que fue diseñado por algunas de las mentes más brillantes para tratar de mantenernos interactuando constantemente», dice Carlton.

Piénsalo de esta forma: si fueras alérgico a cierto tipo de comida y tu refrigerador se comportara como el algoritmo, te metería esa comida en la boca desde el momento en que lo abres. Y si recibes un bocado, la próxima vez que abras tu refrigerador te meterá dos en la boca. El algoritmo no crea contenido ofensivo y, técnicamente, tampoco nos obliga a verlo, pero al igual que la insidiosa Regina George, su influencia lo es todo.

Marie-Claire Chappet es una periodista de arte y cultura residente en Londres y editora colaboradora en Harper’s Bazaar.